Künstliche Intelligenz verändert unseren Alltag – in der Medizin, bei Smart-Home-Geräten, in der Kundenbetreuung oder bei Suchmaschinen. Doch diese Technologien haben auch eine Schattenseite: Deepfakes. Dabei handelt es sich um täuschend echte, aber komplett gefälschte Videos oder Audiodateien, die mithilfe von KI erstellt werden. Die Gefahr? Sie können Menschen diskreditieren, Fehlinformationen verbreiten oder sogar zu Betrug führen.

In diesem Artikel erfährst du, wie Deepfakes entstehen, warum sie so gefährlich sind, wie man sie erkennt und – am wichtigsten – wie du dich davor schützen kannst.

Was sind Deepfakes?

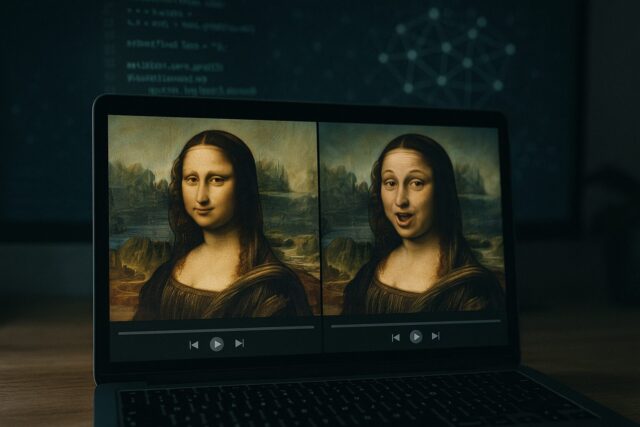

„Deepfake“ ist eine Kombination aus „Deep Learning“ (eine Form des maschinellen Lernens) und „Fake“ (Fälschung). Gemeint sind Audio- oder Videoinhalte, die mithilfe von KI erzeugt wurden, um real zu wirken, obwohl sie komplett manipuliert sind. Die häufigste Technik dahinter sind generative gegnerische Netzwerke (GANs).

Ein Deepfake kann zum Beispiel ein Video sein, in dem eine bekannte Person etwas sagt, das sie nie gesagt hat – mit ihrem Gesicht, ihrer Stimme, ihrer Mimik. Und genau das macht Deepfakes so gefährlich.

Wie werden Deepfakes erstellt?

Noch vor ein paar Jahren war das Erstellen eines Deepfakes aufwendig. Heute gibt es Open-Source-Tools, die es auch Laien erleichtern, täuschend echte Fälschungen zu produzieren. Der typische Ablauf sieht so aus:

-

Datensammlung

Je mehr Fotos, Videos oder Tonaufnahmen einer Person existieren, desto leichter kann ein KI-Modell ihr Aussehen oder ihre Stimme imitieren. -

Modelltraining

Ein neuronales Netzwerk analysiert diese Daten und lernt, wie die Person spricht, sich bewegt oder mimisch reagiert. -

Austausch und Bearbeitung

Die KI setzt das Gelernte in ein neues Video ein und tauscht z. B. das Gesicht oder die Stimme aus. -

Feinschliff

Beleuchtung, Lippenbewegungen und Ton werden optimiert, damit das Ergebnis möglichst realistisch wirkt.

Das Ergebnis: Ein Video, das so echt aussieht, dass es kaum noch von der Realität zu unterscheiden ist.

Warum sind Deepfakes so gefährlich?

Verbreitung von Falschinformationen

Ein Deepfake kann eine Politikerin Dinge sagen lassen, die sie nie gesagt hat – mit realistischem Bild und Ton. Solche Videos können sich rasend schnell verbreiten und die öffentliche Meinung manipulieren.

Rufschädigung und Erpressung

Deepfakes werden zunehmend genutzt, um Menschen zu kompromittieren – etwa durch gefälschte pornografische Inhalte oder Videos mit gewalttätigem Inhalt. Oft steckt Erpressung dahinter.

Finanzielle Betrugsmaschen

Es gab bereits Fälle, in denen CEOs per gefälschter Stimme zur Überweisung hoher Summen aufgefordert wurden – mit Erfolg. Das zeigt: Selbst Unternehmen sind nicht sicher.

Vertrauensverlust in digitale Inhalte

Wenn wir unseren Augen und Ohren nicht mehr trauen können, leidet das Vertrauen in Medien, Nachrichten und die digitale Kommunikation insgesamt.

Wie erkennt man Deepfakes?

Auch wenn Deepfakes immer besser werden, gibt es noch einige Hinweise, die verdächtig sind:

Visuelle Warnzeichen

-

Unnatürliches Blinzeln oder starre Augen

-

Unterschiede bei der Hautfarbe zwischen Gesicht und Hals

-

Lippenbewegungen, die nicht zum Gesprochenen passen

-

Bildstörungen oder „Glitches“ rund ums Gesicht

-

Unnatürliche Lichtverhältnisse oder Schatten

Akustische Warnzeichen

-

Roboterhafte oder stockende Sprache

-

Ton, der nicht synchron zum Bild läuft

-

Echos, digitale Artefakte oder Hintergrundgeräusche

Kontextbezogene Hinweise

-

Die Aussage passt überhaupt nicht zur betreffenden Person

-

Das Video stammt aus einer zweifelhaften Quelle

-

Es verbreitet sich plötzlich viral auf unbekannten Plattformen

Wenn dir ein Video seltsam vorkommt – vertrau deinem Bauchgefühl.

Technische Hilfsmittel zum Erkennen von Deepfakes

KI-basierte Erkennungstools

Unternehmen und Forschungsgruppen entwickeln Werkzeuge, um Deepfakes automatisch zu erkennen:

-

Microsoft Video Authenticator bewertet Videoinhalte in Echtzeit.

-

Deepware Scanner analysiert Videos auf dem Smartphone.

-

Meta/Facebook nutzt eigene Systeme zur Erkennung und Markierung manipulierten Materials.

Blockchain-Technologie

Manche Plattformen setzen auf Blockchain, um Inhalte mit einem digitalen Fingerabdruck zu versehen. So lässt sich nachprüfen, ob ein Video verändert wurde.

Digitale Authentifizierung

Die Content Authenticity Initiative (u. a. von Adobe) will sicherstellen, dass jedes digitale Medium mit Metadaten versehen wird – z. B. wann und wo es erstellt wurde und ob es bearbeitet wurde.

Wie du dich selbst schützen kannst

Überlege genau, bevor du Inhalte teilst

-

Prüfe immer die Quelle: Ist sie glaubwürdig?

-

Lass dich nicht von Emotionen treiben – Deepfakes leben von Schockmomenten und schnellen Klicks.

Gib nicht zu viele persönliche Daten preis

-

Je mehr Bilder und Videos du öffentlich teilst, desto leichter wird es, dich zu imitieren.

-

Achte auf die Privatsphäre-Einstellungen in sozialen Netzwerken.

Nutze Deepfake-Erkennungs-Apps

Apps wie Sensity, Truepic oder Deepware können dir helfen, verdächtige Inhalte zu überprüfen.

Wasserzeichne deine eigenen Videos

Wenn du selbst Inhalte veröffentlichst, verwende digitale Wasserzeichen oder Metadaten – das macht eine spätere Fälschung schwerer.

Erkenne emotionale Manipulation

Wirst du wütend oder erschrocken beim Ansehen eines Videos? Dann ist das vielleicht genau das Ziel. Atme durch – und recherchiere, bevor du teilst.

Die rechtliche Lage

Die Gesetzgebung holt langsam auf:

-

EU: Die Digital Services Act verpflichtet Plattformen zur Kennzeichnung manipulierter Inhalte.

-

USA: Einzelne Bundesstaaten (z. B. Kalifornien) verbieten politische Deepfakes vor Wahlen.

-

Deutschland: Persönlichkeitsrechtsverletzungen, Verleumdung oder Erpressung durch Deepfakes sind strafbar.

Opfer können in vielen Fällen juristisch gegen die Verbreitung vorgehen – allerdings ist die rechtliche Situation oft komplex und hängt vom Einzelfall ab.

Blick in die Zukunft: Was erwartet uns?

Deepfakes entwickeln sich weiter – manche Tools ermöglichen heute schon Echtzeit-Manipulationen in Videocalls oder Livestreams. Umso wichtiger ist es, dass wir aufmerksam und informiert bleiben.

Was wir brauchen:

-

Bessere Tools zur Deepfake-Erkennung

-

Stärkere Gesetze, die Missbrauch klar ahnden

-

Medienkompetenz für alle – schon in der Schule

Die zentrale Frage der Zukunft lautet nicht mehr nur: „Ist das echt?“ – sondern auch: „Woher kommt das?“, „Wie wurde es erstellt?“ und „Was ist das Ziel dahinter?“

Die in diesem Beitrag verwendeten Bilder stammen entweder aus KI-generierter Quelle oder von lizenzfreien Plattformen wie Pixabay oder Pexels.

Hat dir dieser Artikel gefallen? Spendiere mir einen Kaffee!